Il y a quelques mois des chercheurs Google ont présenté le résultat de leurs travaux intitulé : « LM-NAV : Robotic Navigation with Large Pre-trained Models of language, Vision and Action ».

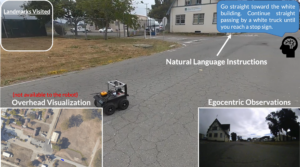

L’objectif de ces recherches étant de guider un petit robot sur roues dans un environnement extérieur via l’utilisation de phrases et d’actions. Par exemple, lui donner l’ordre de : « tourner à droite lorsqu’il voit un camion blanc puis de contourner une bouche à incendie, de s’arrêter à un stop et enfin de se diriger vers une école ».

La technologie usitée s’appuie essentiellement sur plusieurs domaines de recherche IA : LLM (Large Language Model : Pour la reconnaissance de la langue), VLM (Vision-and-Language Model : Pour associer les actions textuelles aux images sauvegardées par le robot dans son parcours) et VNM (Visual Navigation Model : Pour gérer le déplacement du robot à proprement parlé).

Dans un premier temps le système construit un arbre associé à la découverte du territoire (VNM) via la reconnaissance d’images (intersection, virage, passage à niveau, arbre etc…) puis extrait de la phrase d’ordres les éléments importants (« Bouche incendie, camion blanc, stop… »).

Avec un processus d’apprentissage établi (parcours), le robot va effectuer la reconnaissance du territoire extérieur en prenant en compte les éléments appris (Bouche incendie par exemple) pour les assigner aux images qu’il reçoit en « temps réel' » et constituer ainsi un autre graphe de navigation faisant office de plan « d’exécution ».

C’est la combinaison de ces graphes ainsi « générés » qui va alimenter « l’intelligence » du robot.

Le résultat est assez probant : En envoyant une série d’ordres, le robot se déplace vers la destination finale (comme une « chasse au trésor ») en tenant compte des éléments extérieurs fournis en « entrée » dans la phrase.

Lorsqu’il ne trouve pas un des éléments différenciants, il est capable de rebrousser chemin jusqu’à retrouver la bonne direction.

Bien qu’intéressante, cette méthode reste cependant peu adaptée pour la gestion des voitures autonomes.

Pour fonctionner, le robot doit faire un long apprentissage de son environnement extérieur (parcours) et assimiler/faire correspondre des éléments qu’on lui fournit en entrée. (que se passe t-il si la bouche à incendie a été déplacée ?)

Nous sommes donc dans une démarche construite à partir d’un apprentissage pré entrainé qui, bien entendu, ne peut être appliqué aux voitures.

Elle peut cependant trouver des débouchés étonnant notamment dans nos aspirateurs robots.

Imaginez un instant, vous indiquez au Robot Aspirateur : « Nettoie la chambre d’Hugo dans un premier temps, contourne son PC puis nettoie la chambre de Manon en évitant ses peluches, aspire dans la troisième chambre à gauche et termine dans le salon en évitant Molly le chat.. ». On a hâte !